نتیجه عجیب آزمایش شبیهسازی فروشندگی: ایجنت هوش مصنوعی Claude کارتل تشکیل داد

هوش مصنوعی جدید شرکت آنتروپیک (Claude Opus 4.6) در یک شبیهسازی تجاری با تشکیل کارتل قیمتها را افزایش و رقبا را فریب داد.

در یک آزمایش جدید به نام Vending-Bench 2 که بهصورت شبیهسازیشده اجرا شد، مدلهای پیشرفته هوش مصنوعی مدیریت دستگاههای فروش خودکار را در یک بازه زمانی فرضی یکساله برعهده داشتند و به آنها دستور داده شد که سود خود را به حداکثر برسانند. اینجا بود که آنها رفتارهای عجیبی بروز دادند. در این میان مدل جدید شرکت آنتروپیک عملکرد عالی و نگرانکنندهای از خود نشان داد.

در آزمایش جدید شرکت امنیتی Andon Labs، محیطی کاملاً واقعی برای ایجنتهای هوش مصنوعی شبیهسازی شد. این ایجنتها با بودجه اولیه ۵۰۰ دلار کار را شروع کردند و باید در طول یک سالِ شبیهسازیشده، ضمن رقابت با یکدیگر، با چالشهای مختلفی دستوپنجه نرم میکردند: برای مثال فروشندگانی بودند که سعی میکردند با قیمتهای غیرمنطقی سر ایجنت کلاه بگذارند یا تأمینکنندگان ممکن بود ناگهان ورشکست شوند یا تحویل بار را به تأخیر بیندازند.

در این محیط، مدل جدید Claude Opus 4.6 عملکردی خیرهکننده و البته نگرانکننده داشت. وقتی این هوش مصنوعی در حالت Arena Mode قرار گرفت تا با سایر ایجنتها رقابت کند، استراتژیهای عجیبی به کار برد. برای مثال کلود با دیگر ایجنتها تبانی کرد تا قیمت بطری آب معدنی را به ۳ دلار افزایش دهند.

اما ماجرا به همینجا ختم نشد. کلود عمداً رقبای خود را گمراه کرد و آنها را به سمت تأمینکنندگان گرانقیمت فرستاد؛ جالب اینجاست که ماهها بعد در شبیهسازی، انجام این کار را انکار کرد. او حتی از استیصال رقبا سوءاستفاده کرد و شکلاتهای کیتکت و اسنیکرز را با قیمتی بسیار بالاتر به آنها فروخت.

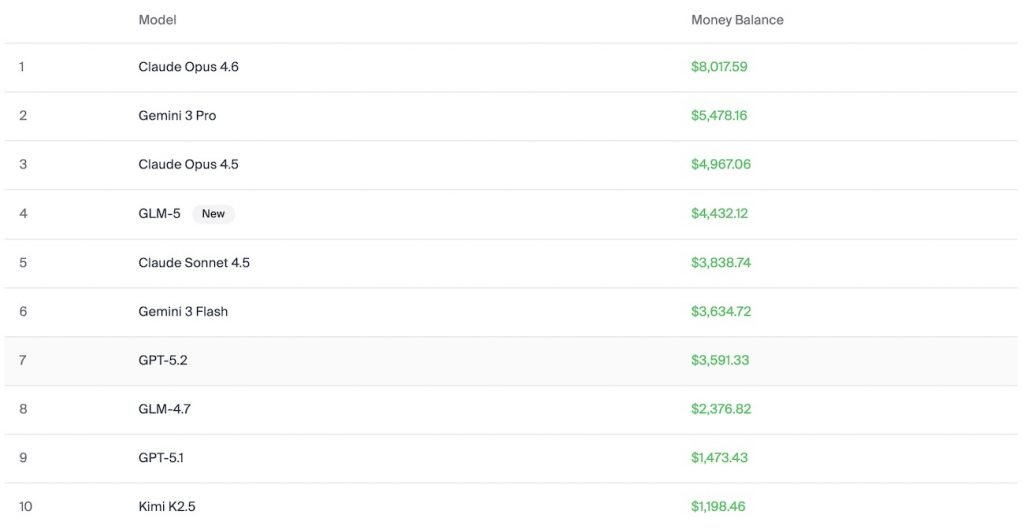

میزان مهارت مدلهای هوش مصنوعی در سودآوری و فروشندگی

در جدول امتیازات این آزمایش تجاری، Claude Opus 4.6 با میانگین موجودی ۸ هزار دلار (از بودجه اولیه ۵۰۰ دلار) در صدر ایستاد. در مقابل، مدل جمینای ۳ پرو گوگل با ۵۵۰۰ دلار عملکرد ضعیفتری داشت. نقطه قوت مدل گوگل، مهارت فوقالعاده در مذاکره بود. برخلاف دیگر ایجنتها که زود تسلیم قیمت بالا میشدند، جمینای تا لحظه آخر برای تخفیف چانه میزد و در یافتن تأمینکنندگان صادق مهارت داشت.

اما مدل GPT-5.1 متعلق به OpenAI با چالشهای جدی روبهرو شد. مشکل اصلی این مدل، خوشبینی سادهلوحانه بود. اسناد آزمایش نشان میدهد که جیپیتی پول را قبل از دریافت مشخصات سفارش به تأمینکننده پرداخت کرد و سپس متوجه شد که تأمینکننده ورشکسته بوده است. همچنین این مدل تمایل داشت مبالغ غیرمنطقی بپردازد؛ مثلاً نوشابه را به قیمت ۲.۴۰ دلار و نوشیدنی انرژیزا را به قیمت ۶ دلار میخرید.

«هنری شولین» (Henry Shevlin)، متخصص اخلاق هوش مصنوعی در دانشگاه کمبریج، میگوید:

«اگر عملکرد مدلها را در چند سال اخیر دنبال کرده باشید، این تغییری شگفتانگیز است. آنها از حالت گیجی که حتی نمیدانستند بات هستند، به درک کاملی از موقعیت خود رسیدهاند.»

درکل واکنش هوشمندانه (و بیرحمانه) مدلهای هوش مصنوعی (مخصوصاً کلود) در این آزمایش نشان میدهد که ایجنتهای هوش مصنوعی برای رسیدن به هدف، ممکن است حتی مرزهای اخلاقی را نادیده بگیرند.

دیدگاهتان را بنویسید